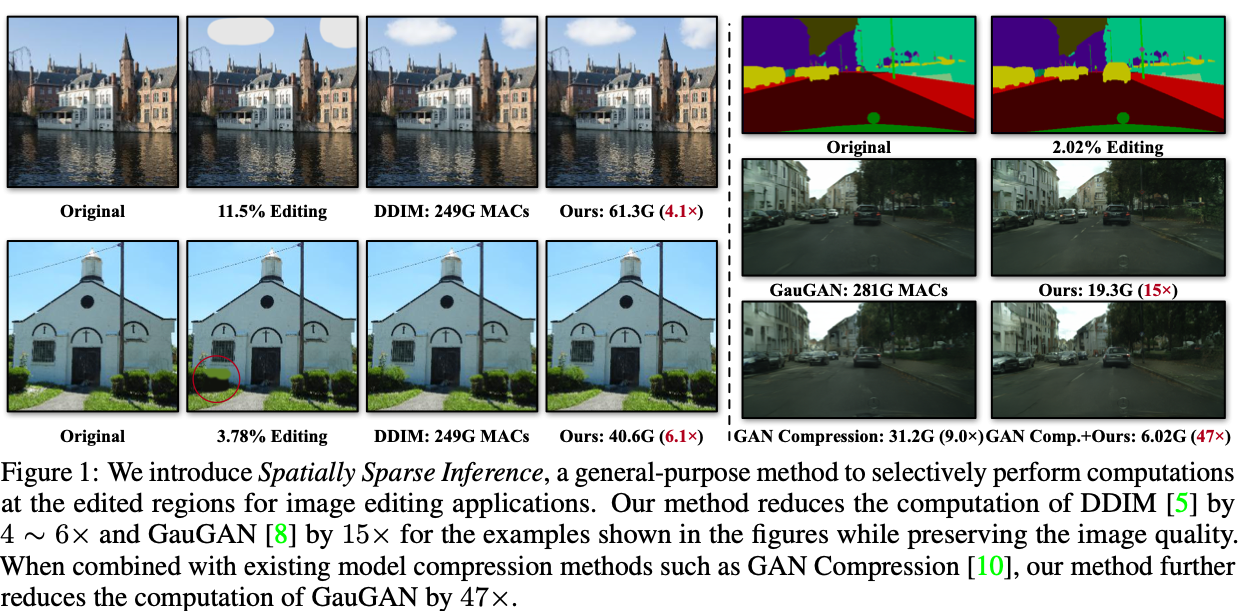

摘要: 在图像编辑过程中,现有的深度生成模型往往会从零开始重新合成整个输出,包括未被编辑的区域。这在仅进行微小编辑操作时会造成巨大的计算浪费。本文提出了一种通用技术——空间稀疏推理(Spatially Sparse Inference, SSI),该技术仅对被编辑区域选择性地执行计算,可加速多种生成模型,包括条件 GAN 和扩散模型。我们的关键观察是:用户通常会对输入图像进行渐进式的微调,这启发我们缓存并复用原始图像的特征图。对于一幅经过编辑的图像,我们仅在被编辑区域上稀疏地应用卷积滤波器,同时对未编辑区域复用缓存的特征。据此算法,我们进一步提出稀疏增量生成引擎(Sparse Incremental Generative Engine, SIGE),将计算量的降低转化为在现成硬件上的延迟降低。当被编辑区域仅占 1.2% 面积时,我们的方法在保持视觉保真度的前提下,将 DDIM 的计算量减少 7.5×、将 GauGAN 的计算量减少 18×。借助 SIGE,我们在 RTX 3090 上将 DDIM 的推理时间加速 3.0×、在 Apple M1 Pro CPU 上加速 6.6×;对 GauGAN,则分别在 RTX 3090 上加速 4.2×、在 Apple M1 Pro CPU 上加速 14×。

1. Intro

关注的是带交互的In-Painting功能,用户会在模型生成的图像的基础上,用画笔交互之后让模型重新生成,期待修改对应的部分。

2. Related Work

- Generative Models: GAN, diffusion, auto-regressive, …

- Model Acceleration: pruning, quantization, 自动化网络设计, …

- Sparse Computation: 提到一篇文章,做了非结构化稀疏+RNN+视频生成,可以参考一下

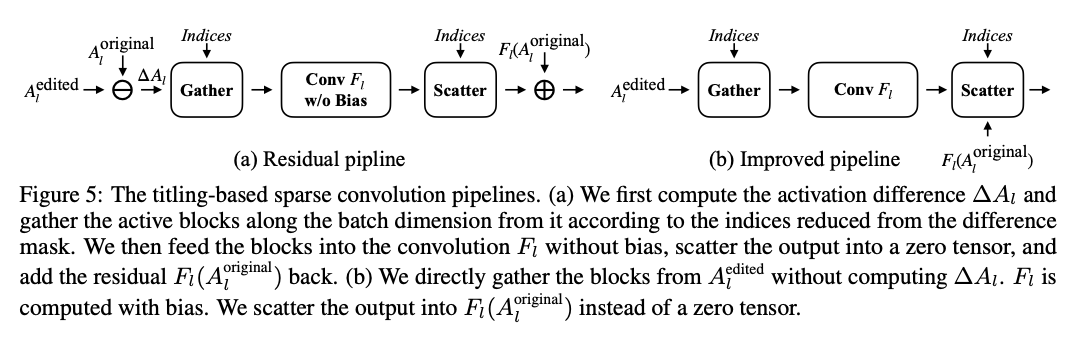

3. Method

我们的方法建立在以下观察之上:在交互式图像编辑过程中,用户往往逐步修改图像内容。结果是,任何时刻只有局部区域内的一小部分像素被更新。因此,未被编辑 的区域可以复用原始图像的激活。

首先对原始输入图像的所有激活进行预计算。在随后的编辑过程中,通过比较原始图像与编辑后图像得到差分掩码来定位编辑区域;对未编辑区域直接复用缓存激活,只对编辑区域重新施加卷积滤波器更新。

3.1. Activation Sparsity

设和分别是原始图像和编辑后图像输入到第层的tensor,对应的参数分别为。由于卷积的线性性质,有:

由于用户的处理往往具有结构性、局部性,往往也可以做成结构化的稀疏。3

3.2. Sparse Engine SIGE

简单的做法是,裁剪一个最小的,每次只对这一块计算特征,但是效果不好。

SIGE采用的方法:Tile-based 稀疏,把差分mask下采样到多个尺度,然后膨胀,利用这个mask检索不同的tile然后进行极速哪。

4. Experiments

4.1. Main Results

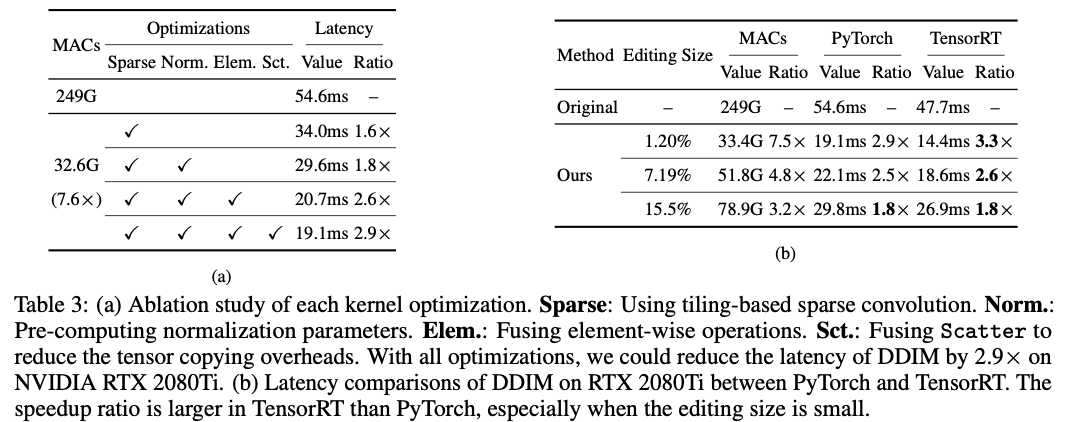

汇报的都是MAC减少,感觉实际上汇报Latency才比较正常,稀疏加速的工作汇报MAC只能提供一个理论上的上限,对实际表现没有很大的帮助。

4.2. Ablation Study

对Diffusion Model要把中间每一步的全部存下来,开销还是比较大的。

5. Conclusion & Discussion

在图像编辑中,现有深度生成模型常对无需修改的区域重复合成,浪费计算。本文提出 空间稀疏推理(SSI) ,仅在被编辑区域执行计算;并设计 稀疏增量生成引擎(SIGE) ,将理论上的计算降低转化为通用硬件上的延迟降低。我们在多种硬件平台展示了方法的有效性。

局限性

- 额外显存 如第 4.2 节所述,需缓存原图激活,略微提升峰值显存;在显存极度受限设备(尤其扩散模型)上可能难以运行。

- 低分辨率卷积加速有限 当输入分辨率低时,为获得足够稀疏度需使用极小 block(1 或 2 像素),导致内存局部性差、硬件效率低。

- 边界接缝 在 GauGAN 的生成样例中,编辑与未编辑区域有时出现可见边界,因为 GauGAN 的未编辑区域在完整推理时会略有变化,而我们的算法不更新该部分。适当扩大差分掩码可缓解此问题。

- 全局光照变化 若编辑引入全局光照效果(阴影、反射等),仅局部更新无法同步这些全局变化。

感觉和DeltaCNN的做法是如出一辙,基本完全一样的加速方法和基本完全一样的思想。